Neural Network Consoleで活性値予測をしてみた

SONYからNeural Network Consoleというのが公開されましたね(以下NNC)。

これの良し悪しを議論できるほどの知識は私にはないです。でもGUIツールということで、とりあえず使ってよう!という試みです。セットアップの方法などは公式に書かれていますので、そちらを参考にしてください。

さて、なにをやってみようかなと考えたのですが、私は仕事柄、画像認識をあまり活用できる身近な内容があまり思いつかなかったので、数値(阻害活性値)の予測をしてみることにしました*1

チュートリアルには画像の分類(MNIST)が書かれているのですが、画像以外の形式を入力にする例はあまり紹介されていません。私はこの記事を参考にしました。

この内容に従えば、とりあえず動きます。ざっくりというと、

の2つがあればいい。という内容です。

データのcsv

今回の場合は、ただの0,1が1024列並んだcsvが化合物ごとに必要ということです。上記はcompound-0についてのもの。これが1つの場所にたくさんある状態が必要です。

これ、誰でも簡単に用意できるものなのでしょうか?

KNIMEを使えば、結構簡単ですよ。過去記事の内容ですべて網羅できますので、あとでちょっと解説します。

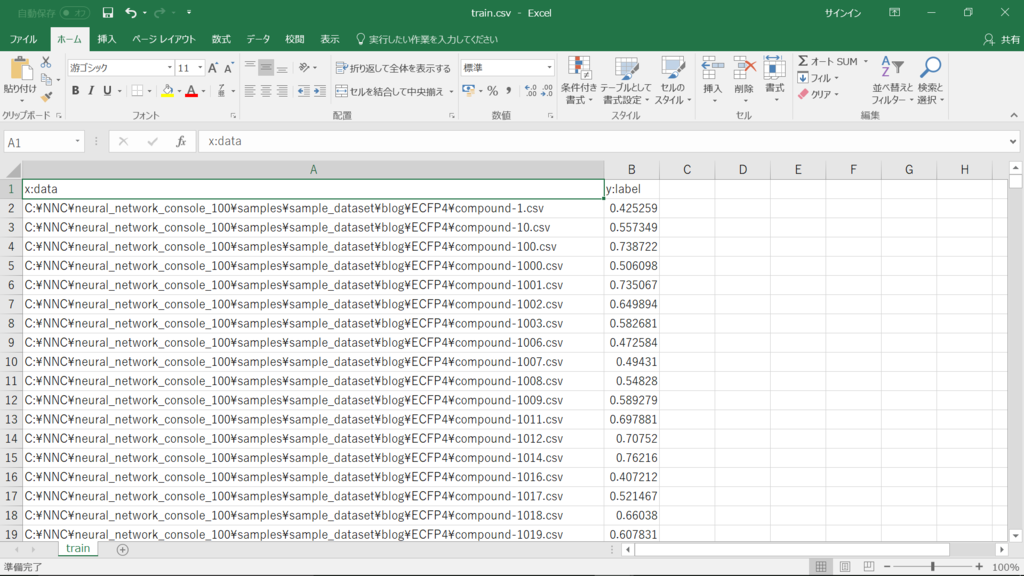

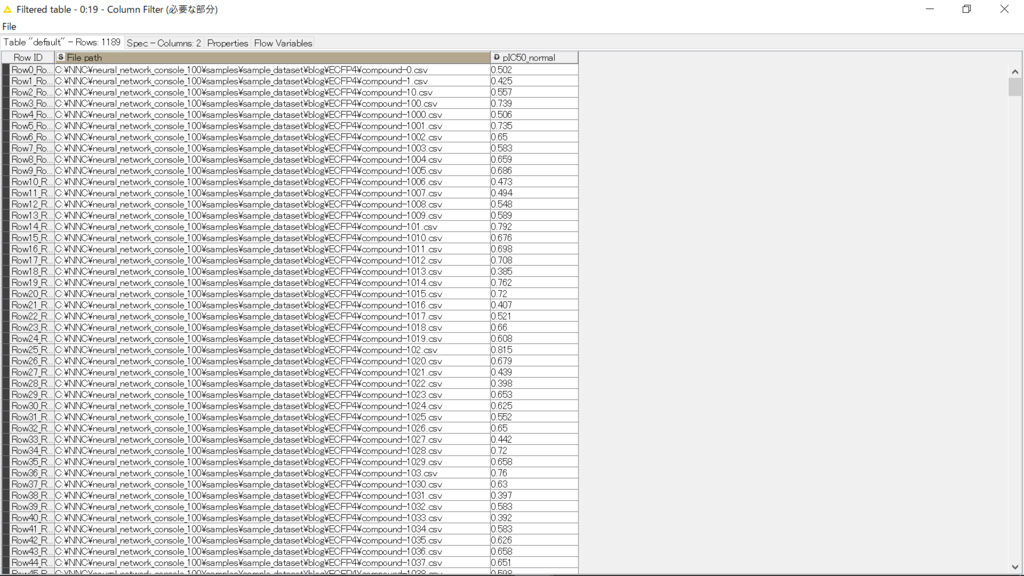

データセットのcsv

これは何を指すかというと

ラベルとは、今回の場合「正解の数値」ですし、分類をしたいならred, blue, greenなどの「正解の種別」に該当するものです。今回は活性値(-1~1にして欲しいみないなので、pIC50を10で割りました)。このリストを作る時もKNIMEで簡単に作れます。

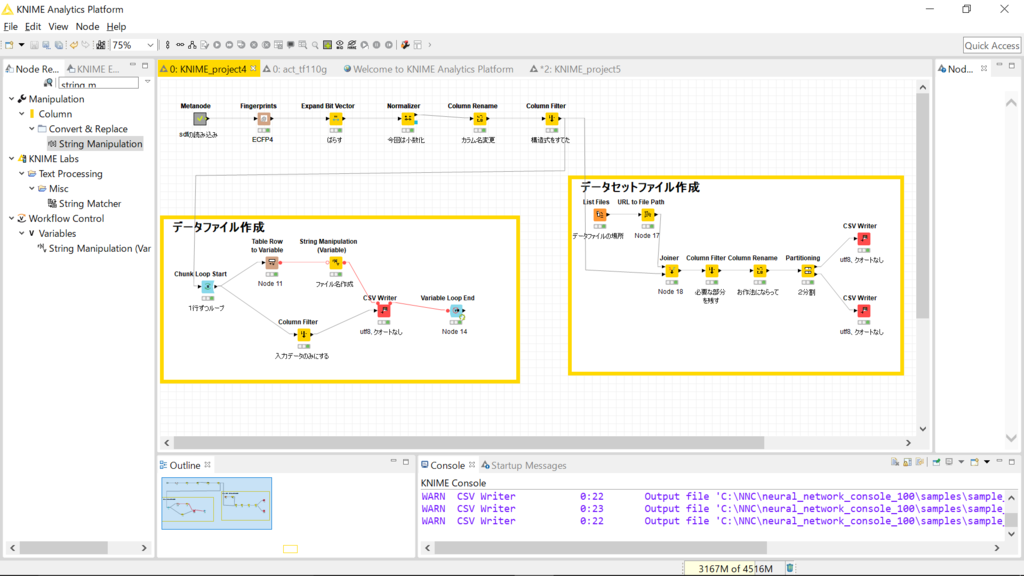

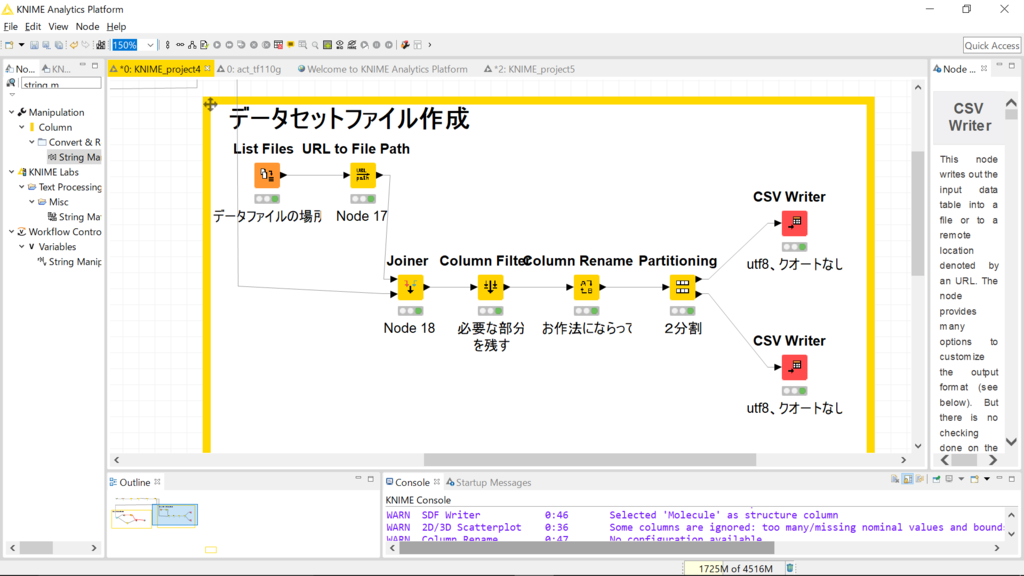

ここまでで紹介した2種の準備物を作成するフローをキャプチャしました。

ちょっと細かいですね。

過去記事のリンクを活用しながら、ざっくりと解説します。

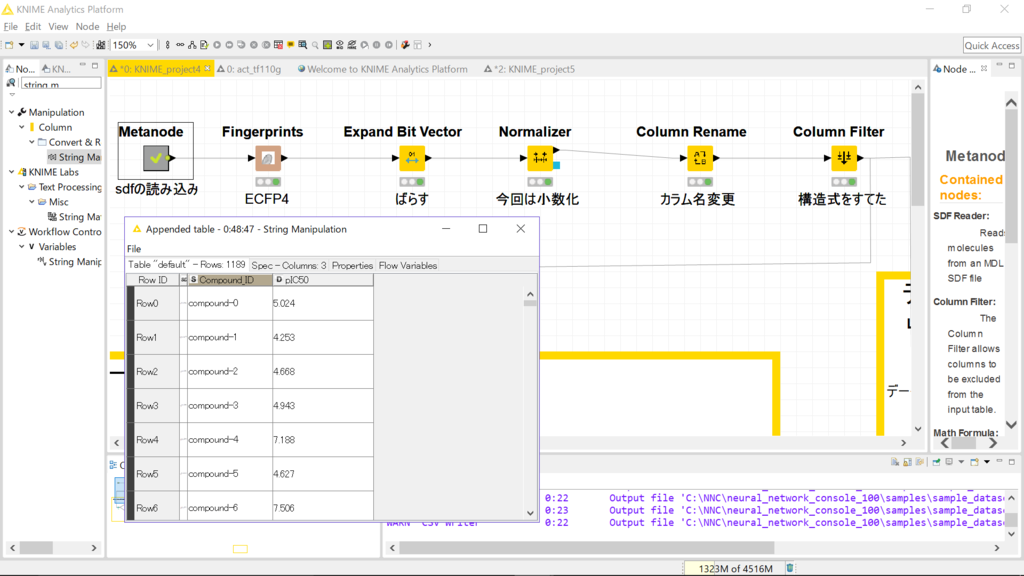

fingerprint関連

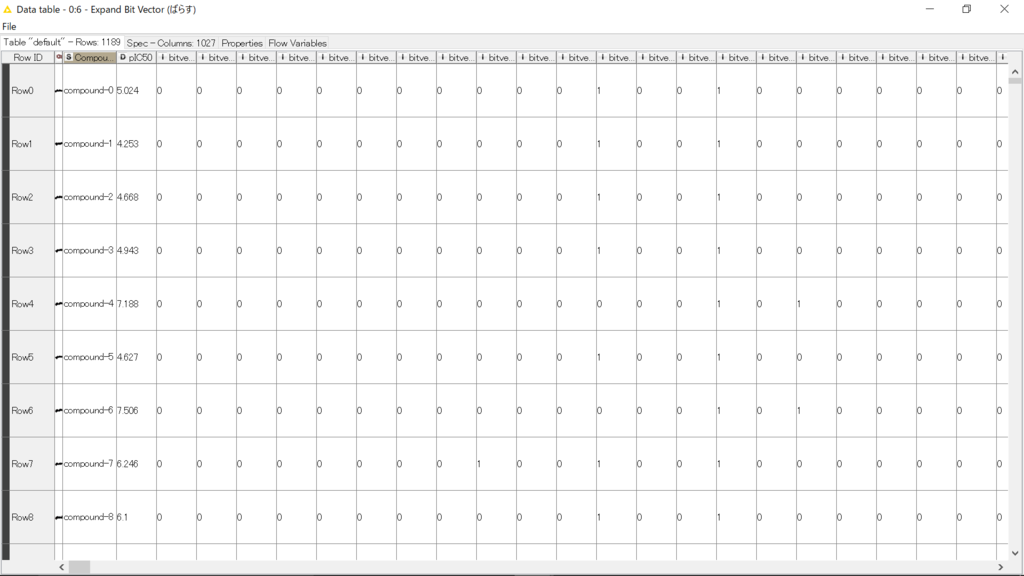

sdfを読んだ後です。化合物のIDとpIC50が入ってます。構造も入ってますが、自分のデータなので見えないようにしてあります。*2

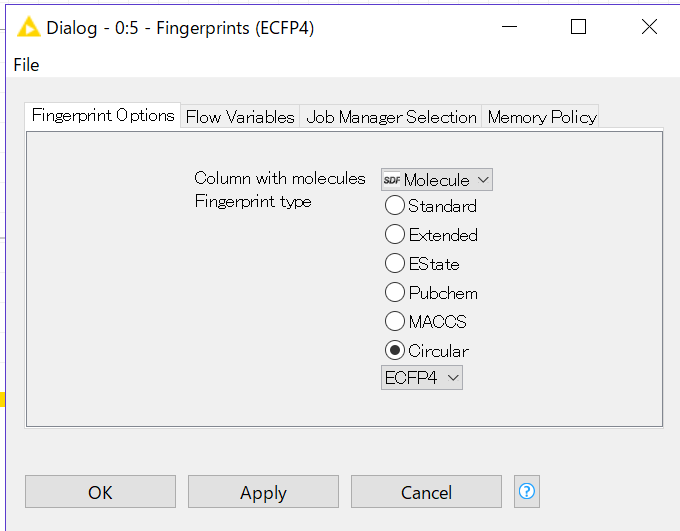

これにFingerprintsというノードを繋げます。

設定画面はこんな感じです。特に意味はありませんが、Circular-ECFP4を今回は選びました。これを実行した後にExpand Bit Vectorというノードをつなげると0,1のビットが1024個、個別のカラムに分割されます。

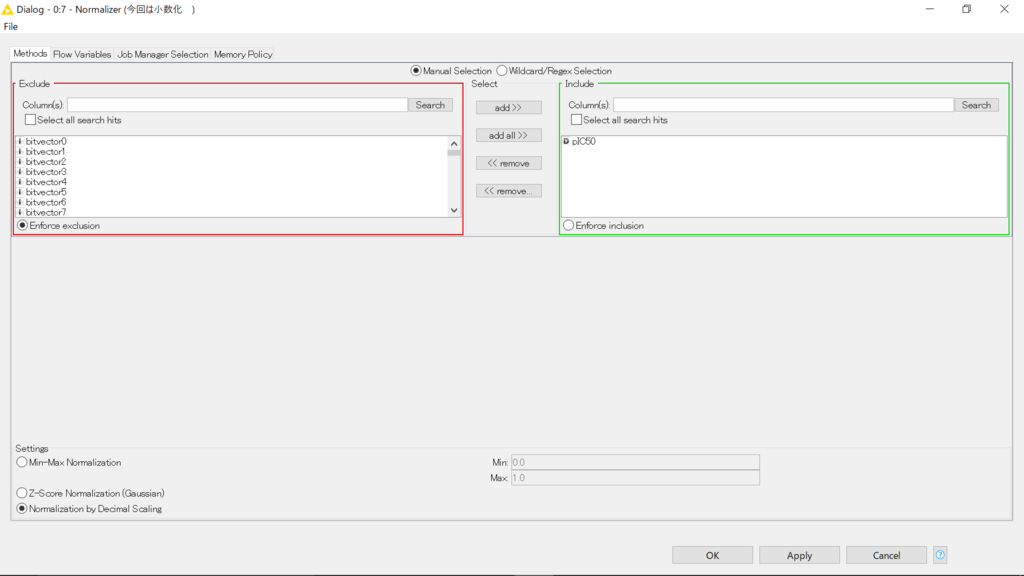

この内容のpIC50をnormalizeします。

normalizerの設定画面です。乱暴かなと思いましたが、単純に小数化しました(キャプチャ左下)。

続くColumn RenameでpIC50というカラム名をpIC50_normalに変更し、Column Filterで構造式のカラムを捨てました(fingerprintを出したので、もういらない)。

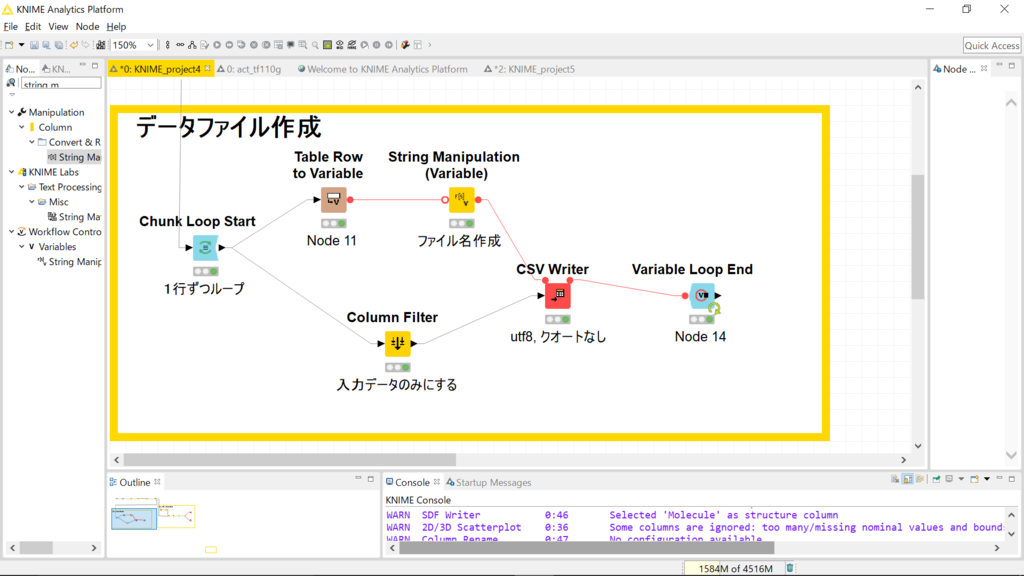

データファイル作成

Loopを使って1行ずつ読み込み、csvに書き出します。分岐上側では、変数化された化合物のIDを「所望の場所+化合物のID+拡張子」になるようにしています。分岐下側では化合物IDとpIC50_mormalを捨てて、fingerprintのみ(学習に使う入力値のみ)になるようにfilterしています。

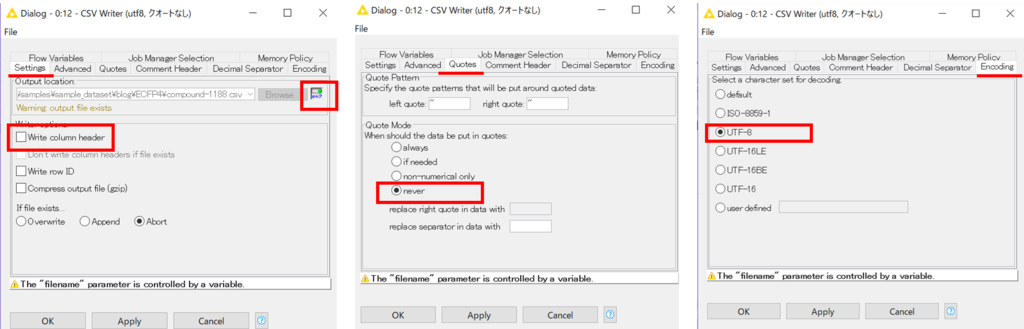

上側分岐からきた変数をファイル名として、csvファイルを書き出します。書き出し時には、カラムヘッダは入れません。また、クオートもつけないように指定しました。文字コードはUTF-8としました。各種タブにて設定可能です。

ここまでで、冒頭のファイルいっぱい状態が出来上がりです。

データセット作成

データをたくさん格納した場所をList Filesで指定します。続けてURL to File Pathを繋ぎます。するとFile nameというカラムができますが、これは今回の例では化合物のIDとして作成してあります。ですので、元のデータの化合物IDとfile nameでアノテーション(joiner)したあとに、いらない項目を除けばおおむね完成です。

データの場所と、活性値(正解の値)だけのテーブルができています。NNCのお作法に従ってカラム名は

- ファイルの場所→【x:data】

- 正解値→【y:label】

に変更します。このtableを学習用と評価用に分割すれば準備完了です。partitioningノードでは様々な方法でデータを分割できます。今回はランダムに80:20に分割しました。この分け方とかも、deeplearningには重要なんだと思いますが、今回はあまり気にしていません。

最後にそれぞれをcsvとして書き出しました。

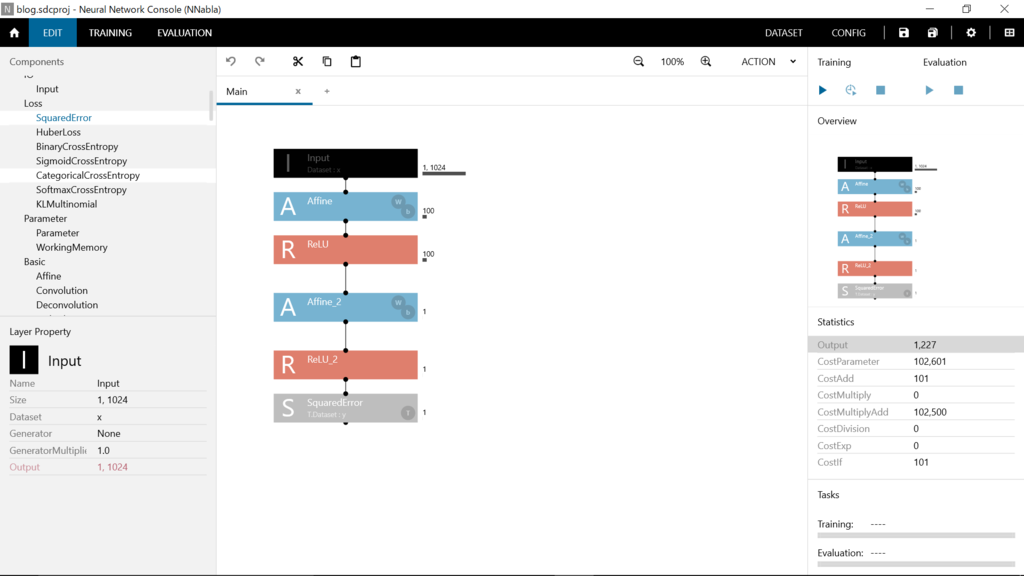

NNCの画面

とりあえず、1024→100→1という感じにしました。最適化法はデフォルトのままでadam、lossはsquared errorにしました。勉強を始めようとしているところなので、意味ねーよこんなのという内容でしたら申し訳ありません。いろいろ教えてくださる方がいると助かります。

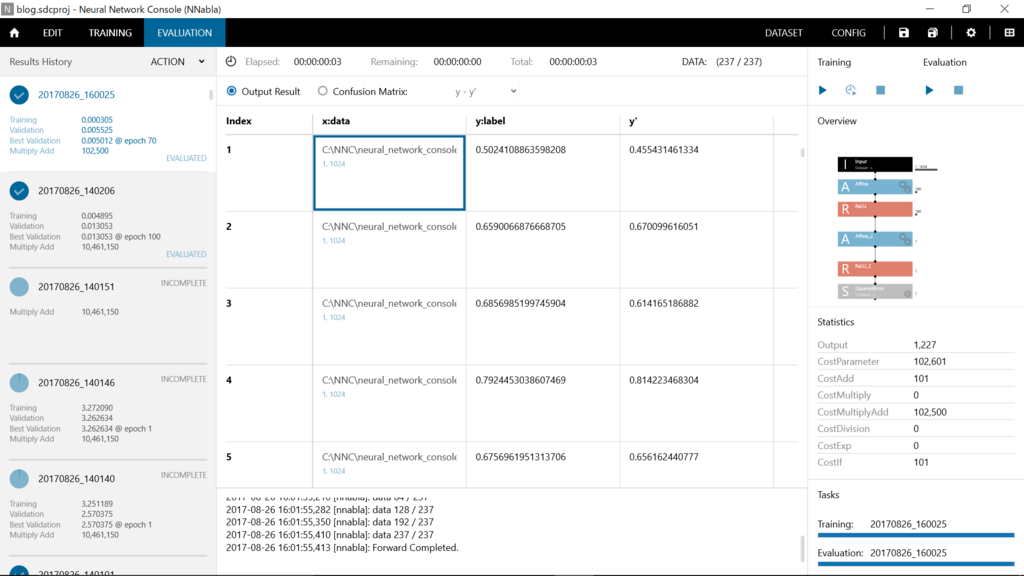

これで学習するとこんな感じのようです。

評価結果はこんな感じ。

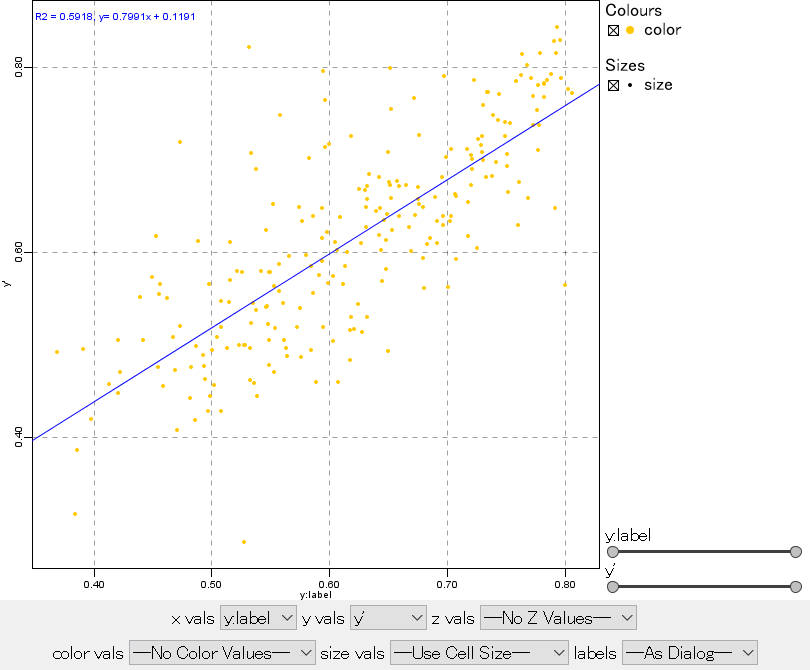

y:labelが正解(pIC50を10で割ったやつ)、y'が予測値になります。

この画面で、右クリックすると内容をcsvで書き出すことも可能です。

書き出したcsvをKNIME上でグラフにしてみました。

ファイルを読み込んで、2D/3DScatterplotにつなぎます。

ちょっと見にくいですが、横軸がy:label(正解)・縦軸がy'(予測値)です。r^2 = 0.59となっています。なかなかの相関ではないでしょうか?繰り返しになりますが、結構狭い範囲での学習・予測なので(ケモタイプが絞られてる)、新たなケモタイプについて予測値を出そうとすれば大外れすると思います。でも、簡単に予測値を出すことができて結構楽しいです。

さて、キャプチャのplotですが、はっきり言ってダサいですね。綺麗じゃないというか、こなれてないというか…。

そうなんです。個人的な意見ですが、KNIMEは可視化に関してはあまり強くはないと思います。情報は得られるがかっこよくない。ですので、私は整形したファイルをspotfireなどに読ませて可視化部分を担当させています。

spotfireは有償なので、オープンソースでかっこよく描画ができるものがあるといいなーと思っています。グラフ内でインタラクティブに動かせるやつがいいです。(ご存知の方がいれば教えてください)

今回は、雑記ということでKNIMEに関する紹介は少ない&雑でしたが、いかがでしたか?私は末端の合成化学者ですので、データ解析や機械学習などについてあまり知識はありませんが、興味はもっています。現役でベンチワークしてますので、あまり勉強する時間が取れないのですが…。

周りにあまり詳しい人もいないので、いろいろと教えてくれる人がいるといいなーと思っています。何かブログ内で間違ったいる部分の指摘とか、色々な関連する面白い技術とか、コメントお待ちしていますので、もし気が向けば宜しくお願いします。

もちろん、ただの感想でも結構です。

ではまた次回!

【KNIME】ノード紹介:Parallel Chunk Start 〜多重影分身するってばよ〜

今回の記事は短めですが、活用できる場面にかなり高い確率で遭遇できると思います。

どんな場面かというと…

この処理、重いんですけど!

という時です。

そんな時は、Parallel Chunkを使いましょう!

Parallel Chunk Start (End)

重たい処理の前後をParallel Chunk StartとEndで挟むことによって、その区間内の処理を分散させて並列処理をすることができます。

今回は、以前に紹介したRenderer to Imageについて並列処理をしていこうと思います。

Loopを使って、複数のファイルを読む方法について紹介した記事の例題で作成した、4335化合物のデータを持つテーブルの構造式部分を画像ファイル(png)に変換しようとする場面を想定してください。

Renderer to Imageノードを接続すれば目的は達成できるのですが、ちょっと処理に時間がかかるんです。私の場合は約100秒かかりました。

やっぱり、ちょっと重い作業を一人で抱え込むのはよくないですよね。そこで、分身を作って作業を分散させるのがParallel Chunkです。

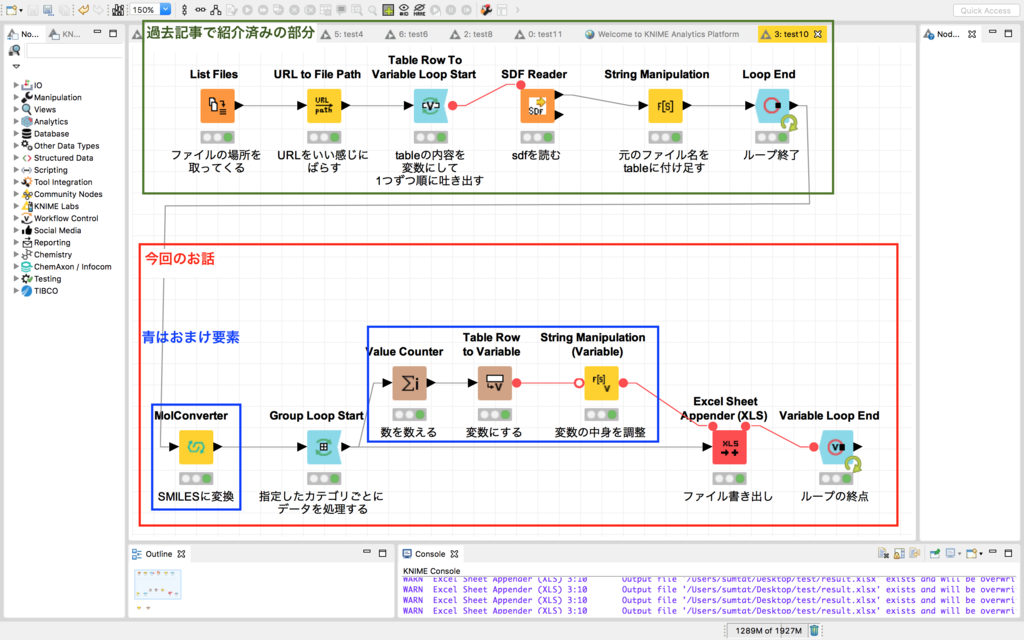

続きを読む【KNIME】ノード紹介:Group Loop Start 〜カテゴリごとに処理したい〜

先日、KNIMEでloopを回すにはどうするか?という記事を書きました。割と興味を持っていただけたのか、たくさんブックマークもして頂きました。ありがとうございます。

こんなニッチな内容でも読んでくださる方がいるというのは嬉しいですし、今後も頑張って書いてみよう!とモチベーションも上がりました。

私も分からないことの方が多いです。もし、もっとお詳しい方がいらっしゃれば、是非コメントなどいただけると嬉しいです。

さてさて、上のリンク記事の例題は、複数のファイルを一気に読むというものでしたが、今回はその逆で

【データの内容を複数のファイルに書き出す】

という作業について紹介してみようと思います。

例では、もう少しひねくれて"1つのエクセルファイルに複数のシートとして分割させる"という内容にしてみました。

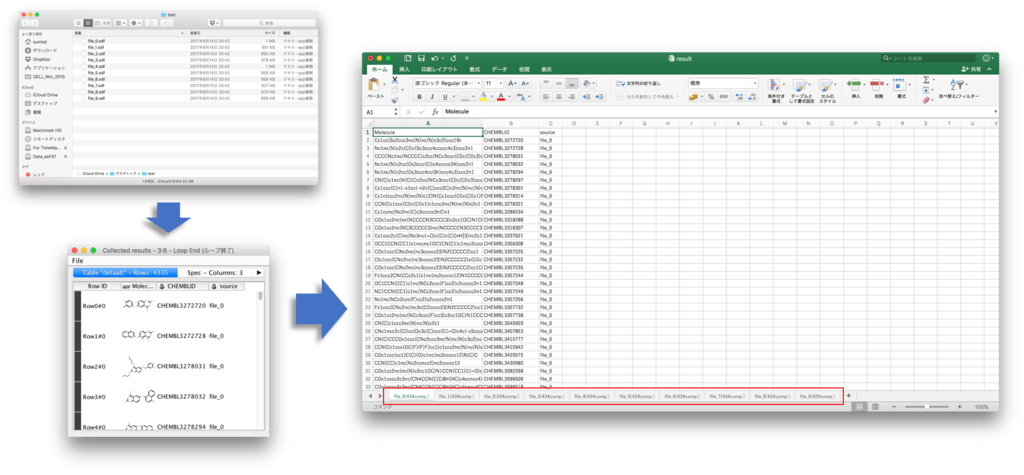

キャプチャに掲げたように、以前の例で紹介したfile_0 ~ file_9をひとまとめにして出来上がったテーブルを、シート名を元のファイル名とした1つのエクセルファイルに書き出してみます。

全体像のキャプチャを載せます↓

基本的には赤枠の部分(青枠を除く)で目的は達成できますが、もう少しおまけ要素を盛り込みました。緑枠部分は過去記事を参照いただければと思います。

それでは順に紹介していきます。

続きを読む

【KNIME】小ネタ:** to variableノードを使わない変数の作り方

ここ何回かの記事で、変数を使った内容を書きました。

-

【超入門】KNIMEで変数を使うには 〜今日の日付をエクセルのシート名にして書き出してみよう〜 - 非プログラマーのためのインフォマティクス入門。(仮)

-

【超入門】Loopを回せ! 〜KNIMEを使って複数のファイルを一気に読んでみよう〜 - 非プログラマーのためのインフォマティクス入門。(仮)

個人的には、変数に関しては「これが基本かな?」という方法を書きましたが、他にも何かしらの値を変数に指定する方法があるので、2つ紹介します。

Workflow内のどこでも使えるglobalな変数

この場合は、変数は固定値になりますが。

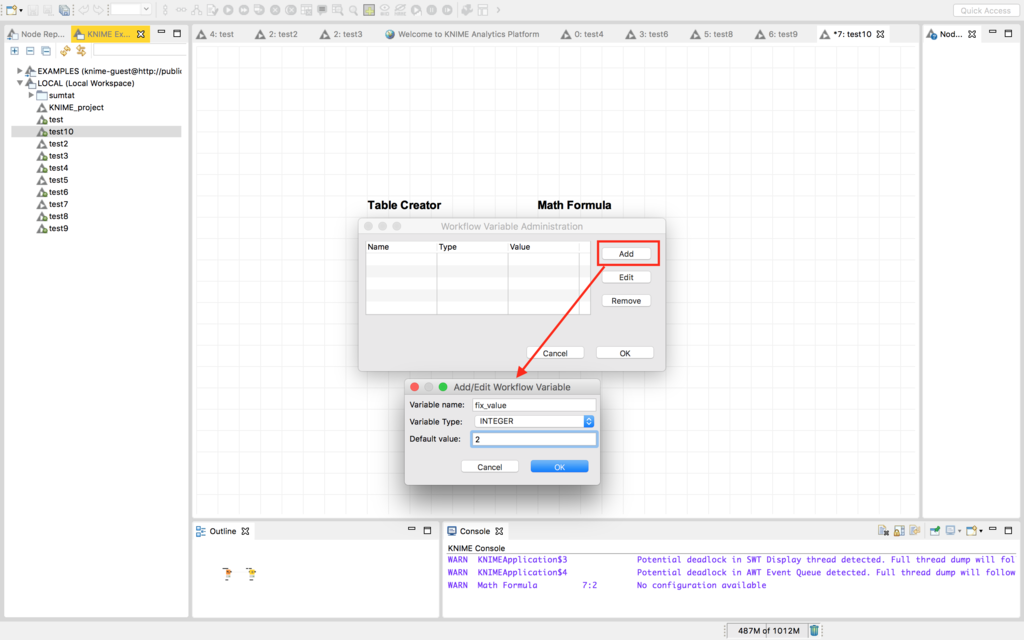

まずはKNIME explorerの中から、指定のflowを選び右クリックメニューを出します。今回の例ではtest10という名前のflowです。メニューの中にWorkflow Variables...というのがあるので、選択します。

次のような新たなウインドウが開くので、addを選びます。今回の例ではfix_valueという名前の変数を設定することにします。タイプは整数値、値は2として設定します。

入力が終わったらOKします。

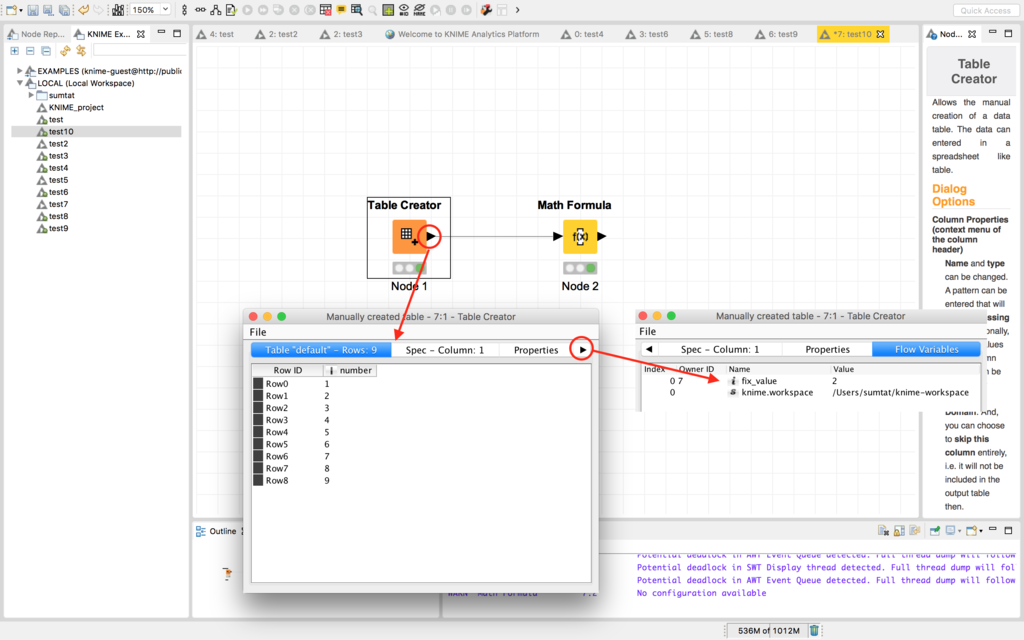

これでおしまいです。このworkflow上では、どこでもfix_value(値は2)という変数が使えるようになっています。確認してみます。

以前にちょっと紹介したTable Creator使って、1から9が入っているテーブルを作りました。Tableというタブではなくて、Flow Variablesというタブを探して内容を確認すると確かにfix_valueという変数名で2という値を持っていることが分かります。

続きを読む

【超入門】Loopを回せ! 〜KNIMEを使って複数のファイルを一気に読んでみよう〜

勝手に偉そうな命名をした"超入門シリーズ"ですが、これまでに

について紹介してきました。

さていよいよ今回はループの回し方について紹介したいと思います。

この3つが揃えば、データサイエンティストやプログラミングガチ勢ではない、私のような専門外の人間でも、ある程度のルーチンワークをKNIMEにお願いすることができるようになります。

今回は例として、

【複数のファイルを一気に全部読み込む】という作業にtryしてみます。

読み込むファイルの形式はsdfというものにして説明しますが、エクセルでもcsvでも、大体流れは同じです。

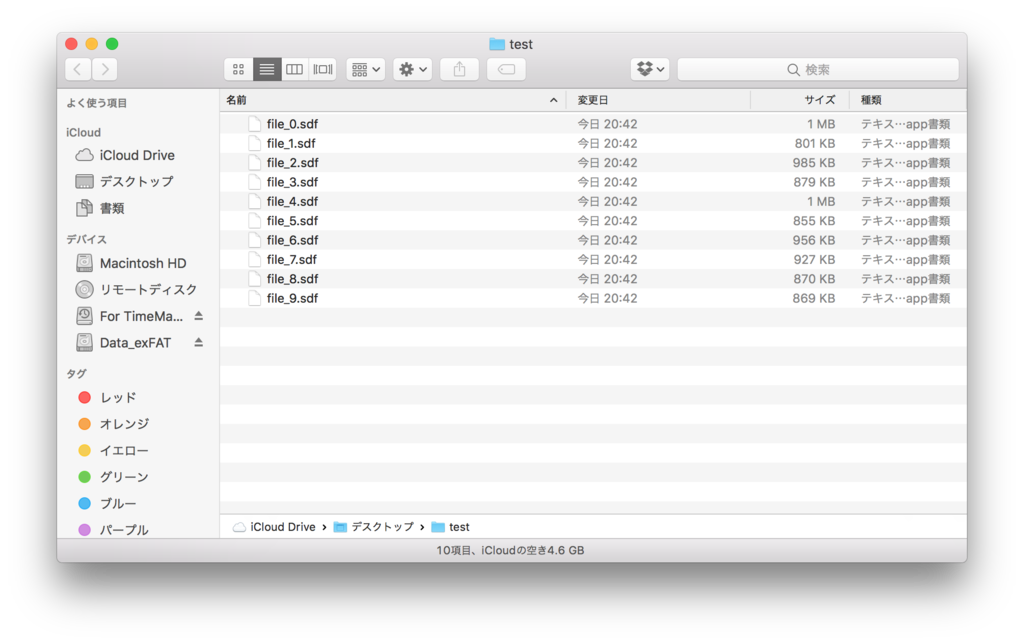

さて、状況のイメージです。

ひとつのフォルダに読みたいファイルが全て入っているものとします。今回の場合は、testという名前のフォルダにfile_0.sdf ~ file_9.sdfという10個のファイルが格納されています*1。これを一気に読んでいこうと思います。

あんまりピンとこないでしょうか?

- 10人から集めたファイルを一つにしたい

- 毎月のレポートを10ヶ月分まとめて解析したい

などなど、色んな場面が考えられると思うので、皆様の状況によく合うものをイメージすると活用に繋がるのではないでしょうか?

それでは、KNIMEの操作について紹介します。

*1:ファイルの日付に注目して下さい。全部同じ時間ですね。今回の例題として使った10個のファイルは、もともと1つだったファイルをKNIMEを使って私が10分割したものです。これもloopを使った処理により作成しています。色々簡単にできます

【KNIME】小ネタ:変数受け渡しに使う"赤線"の活用法

前回の記事の最後に、こんなキャプチャを載せました。

●ー●の繋がりは、基本的には変数の受け渡しを行うためのものです。上記の例だと、Table Row to Variableで日付データを変数として、Excel Writerに渡す部分だけあれば目的は達成できるはずなんですよね。解説にもそう書きました。

では、最初のExcel ReaderとTime Generatorを赤線で繋ぐことに、何かadvantageがあるんでしょうか?

…無いのにわざわざ話題にしないですよね。はい、いいことあります。

結論を言うと、

workflowの動きをコントロールできる

ということです。

では例を挙げて紹介します。

続きを読む【超入門】KNIMEで変数を使うには 〜今日の日付をエクセルのシート名にして書き出してみよう〜

今回*1は変数*2の使い方について、基本的な部分を書いてみようと思います。あまり馴染みのない方もいらっしゃるかもしれませんが、

- 変数なし:すべて徒歩でプレイ

- 変数あり:キメラのつばさ使える

くらいに幅が広がると思います。

(さらにループ処理ができればルーラですかね。それはまた別の機会にしましょう)

題材として、

【作業(stock:noを取ってくる)をしている日付を、書き出すエクセルのシート名にする】

ということをしてみようと思います。

*1:記事の作成日は2017/08/12です

*2:変数について書かれている記事はweb上にたっぷりあるので、好みのものを探して読んでみるのが1番いいと思いますが、"状況により変わる数(データ)"のことです。

例えば今回の記事では【変数="本日の日付グループご担当者様"】みたいな感じでしょうか?今日の時点では【"2017/08/12さん"が実際の担当者=実際の変数の値】みたいな感じです。明日の担当者は"2017/08/13さん"になるし、その後も変わっていく数ですよね。

*場合によっては変数といいながらも内容が変わらないこともあります。"変わることができる数"といったほうが適当かもしれません